GPT-3 模型包含大量的语言数据,能够理解语言的语法和语义。当用户输入问题时,ChatGPT 会将问题转换为计算机能够理解的数据,并使用 GPT-3 模型进行处理。GPT-3 模型会根据语言数据,生成一个回答候选集,并从中选择一个最佳回答。最终,ChatGPT 会将生成的回答以自然语言的形式返回给用户。

如此复杂的模型是怎么训练的呢?

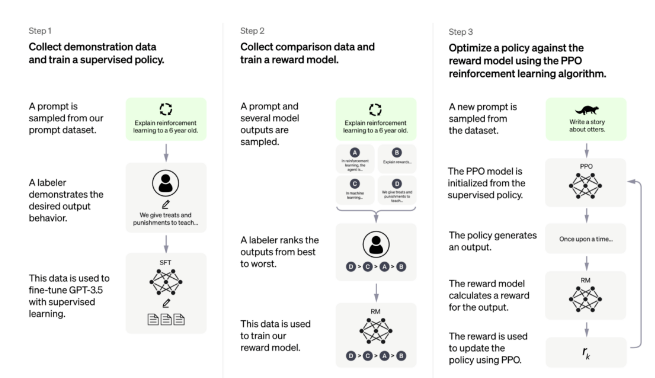

简单来说是 RLHF(从人类反馈中强化学习),分三步:

1.收集提示信息(prompt)和人工形成的任务示例(demonstration),并用监督学习方法训练模型。

2. 将初始模型用在新的对比数据上,生成多个输出,人工对这些输出进行排序,排序结果用于训练奖励模型。

3.使用PPO(Proximal Policy Optimization)强化学习算法训练奖励模型。